本文目录导读:

在手游的世界里,我们时常会遇到各种各样的文本信息,比如游戏公告、玩家评论、社区讨论等,这些信息不仅数量庞大,而且种类繁多,如何高效地管理和利用这些文本信息,成为了手游运营和玩家社区管理的一大挑战,我们就来聊聊如何利用BERT模型,通过微调的方式,打造一款专属的手游文本分类神器,让文本管理变得更加轻松和智能。

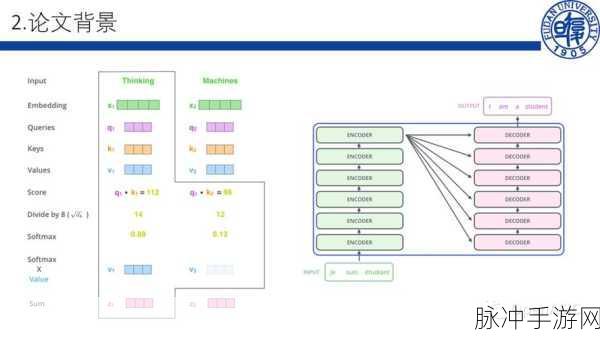

BERT,全称Bidirectional Encoder Representations from Transformers,是Google开发的一种强大的自然语言处理(NLP)模型,它基于Transformer的深度神经网络架构,能够一次性处理整个输入文本,因此可以更有效地捕捉单词之间的上下文关系,BERT是一个预训练模型,这意味着它已经在大规模的语料(如书籍、文章和网页)上训练过,掌握了语言的结构和语义,通过微调,我们可以让BERT适应特定的下游任务,比如文本分类。

如何微调BERT模型来做文本分类任务呢?我们就来一步步揭秘这个过程。

准备数据集

我们需要准备一个包含多个类别的文本数据集,这个数据集应该涵盖手游中可能出现的各种文本类型,比如游戏公告、玩家评论、攻略分享等,每个类别应该有足够的样例以供训练,我们还需要将数据集划分为训练集、验证集和测试集,以便在训练过程中监控模型的性能,并调整参数以获得更好的表现。

数据预处理

在将数据输入BERT模型之前,我们需要进行一些预处理工作,由于BERT模型对输入序列的长度有一定的要求,我们需要确保所有输入序列的长度一致,如果序列长度不一致,可以使用填充(padding)技术使其长度一致,我们还需要将类别标签转换为BERT可以处理的格式,通常可以使用one-hot编码或整数编码来表示不同的类别标签。

设定训练参数

在开始训练之前,我们需要设定一些关键的训练参数,如学习率、批大小、训练轮数等,这些参数将直接影响模型的训练过程和最终表现,学习率的选择很重要,过大可能导致模型不收敛或过拟合,过小则可能导致训练速度过慢或收敛不到好的解,批大小也是一个重要的参数,它影响模型的训练速度和内存消耗,训练轮数要适量,过多的训练轮数可能导致过拟合,而太少的轮数则可能无法使模型充分收敛。

训练模型

我们就可以开始训练模型了,使用训练集对BERT模型进行训练,在训练过程中,可以通过验证集来监控模型的性能,并根据需要调整参数以获得更好的表现,由于BERT模型是一个预训练模型,它已经掌握了大量的语言知识和结构信息,因此我们可以通过微调的方式,让模型快速适应特定的文本分类任务。

评估与优化

训练完成后,我们需要使用测试集对微调后的模型进行评估,以了解其泛化能力,还可以通过计算准确率、精确率、召回率和F1得分等指标来评估模型的性能,如果模型的性能不够理想,我们可以尝试一些优化技术,比如使用不同的预训练数据、调整学习率策略、增加正则化项等,以获得更好的性能。

实战应用

在手游领域,微调后的BERT模型可以应用于多个场景,我们可以利用这个模型对游戏公告进行自动分类,帮助玩家快速找到感兴趣的内容,或者,我们可以对玩家评论进行情感分析,了解玩家对游戏的满意度和意见反馈,还可以将模型应用于社区管理,对违规言论进行自动识别和过滤,维护良好的社区氛围。

最新动态

热点一:王者荣耀智能社区管理

在《王者荣耀》这款热门手游中,玩家社区的管理一直是一个重要的问题,通过微调BERT模型,我们可以实现智能社区管理,对玩家评论进行自动分类和情感分析,当玩家发表评论时,模型可以自动识别出评论中的关键词和情绪倾向,如果评论包含违规内容或负面情绪,系统可以及时进行干预和处理。

热点二:和平精英游戏公告分类

《和平精英》作为一款射击类手游,经常需要发布各种游戏公告和更新信息,通过微调BERT模型,我们可以实现游戏公告的自动分类和摘要提取,当游戏发布新公告时,模型可以自动识别出公告的类型和关键信息,并生成简洁明了的摘要,帮助玩家快速了解公告内容。

热点三:原神玩家攻略分享推荐

在《原神》这款开放世界手游中,玩家经常会在社区中分享自己的游戏攻略和心得,通过微调BERT模型,我们可以实现玩家攻略的自动分类和推荐,当玩家在社区中发布攻略时,模型可以自动识别出攻略的类型和难度等级,并根据玩家的游戏进度和兴趣偏好进行推荐,帮助玩家更好地享受游戏。

微调BERT做文本分类的特别之处

微调BERT模型来做文本分类任务的最大特别之处在于其高效性和准确性,由于BERT模型已经在大规模的语料上进行了预训练,掌握了丰富的语言知识和结构信息,因此通过微调的方式可以快速适应特定的文本分类任务,BERT模型采用了双向编码器的结构,能够更有效地捕捉单词之间的上下文关系,从而提高了文本分类的准确性,微调BERT模型还可以根据具体任务的需求进行灵活调整和优化,以满足不同场景下的应用需求。

微调BERT模型来做文本分类任务是一种高效、准确且灵活的方法,在手游领域,这种方法可以帮助我们更好地管理和利用文本信息,提升游戏运营和玩家社区管理的效率和质量,希望这篇文章能够帮助大家更好地了解和应用BERT模型,打造属于自己的手游文本分类神器!